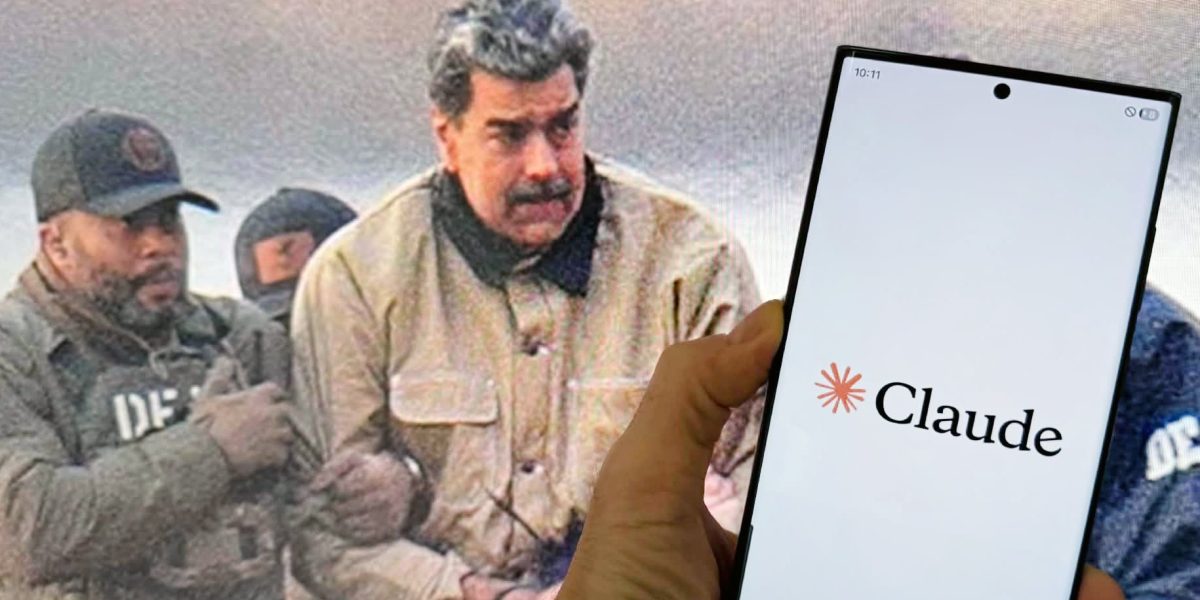

Armata SUA a recurs la inteligența artificială Claude, dezvoltată de compania Anthropic, în timpul unei operațiuni de amploare care a vizat capturarea lui Nicolás Maduro în Venezuela. Acest detaliu devastator a renegat liniile vechi ale eticii tehnologice și a reaprins dezbaterile cu privire la utilizarea AI în cadrul misiunilor clasificate și sensibile, aducând în prim-plan o dilemă etică și de securitate națională. Într-un context în care tehnologia avansează rapid și intră tot mai mult în zone cu grade înalte de secretomanie, această poveste revelatoare ridică semne de întrebare despre limitele și responsabilitățile dezvoltatorilor și ale autorităților militare.

### AI-ul Claude, un aliat discret în operațiunile de securitate

Potrivit informațiilor apărute recent, armata americană a folosit modelul de inteligență artificială Claude, creat de compania Anthropic, în cadrul unei misiuni care a dus la prinderea liderului venezuelean. În spatele acestei utilizări se află un parteneriat între Anthropic și Palantir, o companie de analiză de date cu influență majoră în domeniul apărării și intelligence-ului. Platformele Palantir sunt folosite pe scară largă de Departamentul Apărării din SUA și agențiile federale, ceea ce face ca integrarea AI-ului Claude să fie mai puțin vizibilă, dar și mai integrală pentru echipele de securitate.

Reuters semnalează că această utilizare nu poate fi independent verificată, iar reprezentanții Pentagonului, Casa Albă, Anthropic sau Palantir nu au răspuns la solicitările de comentarii. Totodată, această situație a readus în discuție îngrijorarea cu privire la modul în care tehnologiile AI pătrund în domenii ultra-sensibile, precum cele ale operațiunilor militare clandestine și ale serviciilor de informații. În timp ce tehnologia devine tot mai sofisticată, întrebarea dacă și cum poate fi controlată rămâne fără răspuns clar, lăsând loc pentru speculații și temeri legate de posibile abuzuri.

### Presiuni pentru acces deplin la AI pe rețele clasificate

Un aspect alarmant dezvăluit de analiști și jurnaliști specializați privește presiunile exercitate de Pentagon asupra gigantilor din domeniul AI, precum OpenAI și Anthropic. Oficialii militari și cei din domeniul securității militare încearcă să obțină acces la modelele AI, inclusiv Claude, pe rețele și platforme clasificate, cu reguli mai puțin stricte decât cele aplicate pentru publicul larg. Această strategie vizează accelerarea procesului de adoptare și adaptare a tehnologiei AI pentru misiuni ultra-sensibile, în condițiile în care timpul și securitatea devin resurse tot mai limitate.

Prin această abordare, oficialii de la Pentagon speră să beneficieze de avantajul competitiv al AI-ului, dar și să reducă timpul necesar pentru decizii cruciale, în mediile în care datele sunt extrem de sensibile și de protejat. Problema însă este că această dezvoltare vine în contradicție cu politicile publice ale companiilor dezvoltatoare, care în general interzic folosirea AI pentru sprijinirea violenței sau activități ilicite.

### În pragul unui precedent periculos

Cazul în care Claude a fost utilizat pentru capturarea lui Maduro, în condițiile în care politica Anthropic interzice explicit folosirea AI-ului pentru activități violente sau de supraveghere, ridică semne de întrebare asupra granițelor etice și legale ale tehnologiei. Dacă se dovedește că AI-ul a contribuit direct sau indirect la o operațiune de forță, rămâne de văzut dacă și cum va fi influențată reglementarea internațională a utilizării acestor tehnologii.

Mai mult decât atât, dacă astfel de practici vor continua, ele vor putea destabiliza regulile existente și vor alimenta presiuni pentru o reglementare mai strictă sau chiar pentru interzicerea anumitor algoritmi în domeniul securității. În timp ce specialiștii atrag atenția asupra pericolului de a periclita echilibrul etic și legal, guvernele și companiile se află în fața unei decizii delicate: cum să asigure securitatea națională fără a compromite integritatea principiilor fundamentale.

Pe măsură ce cercetările și utilizarea AI în domeniul militar avansează, un lucru este cert: întrebările despre responsabilitate, transparență și limitele tehnologiei sunt mai relevante ca niciodată. Într-un peisaj geopolitic în continuă schimbare, apariția modului în care AI-ul poate fi integrat în operațiuni clasificate va fi, cu siguranță, subiectul principal al discuțiilor în următorii ani.